企業(yè)網(wǎng)站建設(shè)提高收錄的方法:編寫合理的robots文件

企業(yè)網(wǎng)站建設(shè)好后,想要被收錄,那就需要讓搜索引擎蜘蛛來抓取,一般最理想的情況是可以不設(shè)限制,讓蜘蛛抓取網(wǎng)站的全部內(nèi)容。但是每個(gè)網(wǎng)站都有不希望展示出來的東西,比如用戶數(shù)據(jù)、登陸信息等等,這個(gè)我們一般是要禁止蜘蛛抓取的,所以我們既要對蜘蛛放行,又要做出一定的限制。想要達(dá)到這個(gè)效果,那就需要使用到robots.txt文件,下面悅?cè)痪W(wǎng)絡(luò)工作室就給大家介紹一下robots.txt文件的規(guī)則寫法。

一、不設(shè)限制,讓蜘蛛自由抓取

如果你的網(wǎng)站沒有需要隱藏的內(nèi)容,那就可以不對蜘蛛做限制,這種情況下可以直接刪除robots.txt,也可以在robots.txt文件中填寫如下內(nèi)容:

User-agent: *

Allow: /二、限制部分內(nèi)容

大多數(shù)情況我們是不可能讓蜘蛛無限制的抓取的,這樣會嚴(yán)重泄露網(wǎng)站的隱私,對安全不利。所以我們需要對某些目標(biāo)做限制,一般情況下限制的內(nèi)容有網(wǎng)站后臺、用戶數(shù)據(jù)等,這個(gè)會根據(jù)網(wǎng)站的類型,網(wǎng)站程序,寫法會有一些不同,以wordpress制作的網(wǎng)站為例,一般情況下可以這樣寫robots.txt文件:

User-agent: *

Disallow: /wp-admin/

Sitemap: http://www.wto86.com/sitemap.xml其實(shí)有很多網(wǎng)站之所以不被收錄,與robots.txt文件設(shè)置錯(cuò)誤是有很大關(guān)系的,比如有人網(wǎng)站可能是直接制作的別人的robots.txt文件,如果別人是錯(cuò)的,那你的也是錯(cuò)的,比如下面這樣:

User-agent: *

Disallow: /這樣的寫法是告訴搜索引擎蜘蛛禁止抓取網(wǎng)站的所有內(nèi)容,這樣網(wǎng)站自然就很難被收錄了。

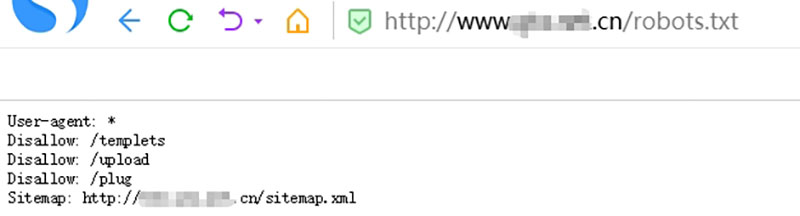

三、編寫robots.txt

如果你robots.txt的寫法比較了解,直接按你的需要編寫就好了,如果你不會也沒關(guān)系,你可以直接參考一下同行的寫法,直接在瀏覽器輸入同行的網(wǎng)址加下robots.txt回車就可以看到了,然后可以根據(jù)需要復(fù)制下來,保存到記事本,然后文件名robots.txt,再上傳到網(wǎng)站根目錄即可。

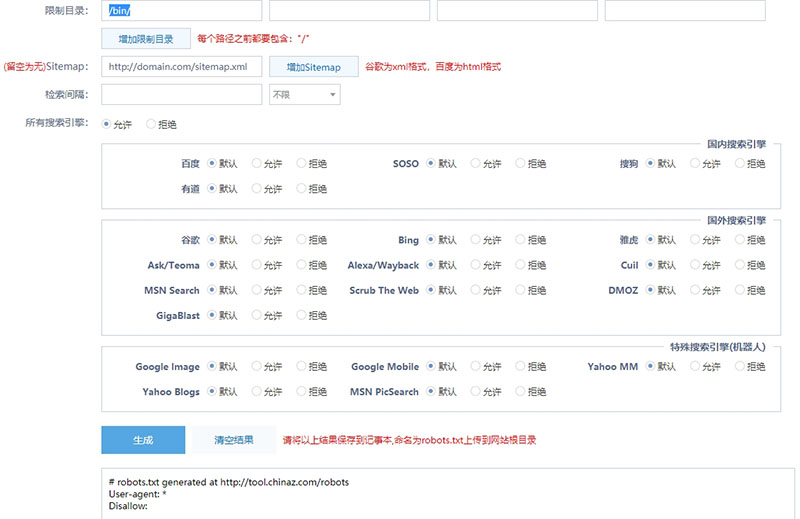

如果不確定同行的是否適合你,也可以使用一些在線robots.txt生成工具,比如這個(gè)網(wǎng)址tool.chinaz.com/robots/,按需填寫和勾選里面的選擇,然后點(diǎn)生成就可以了,最后把把文件復(fù)制到記事本,命名為robots.txt,最后上傳上網(wǎng)站根目錄即可。

建站案例欣賞

網(wǎng)站模板

? Copyright 2024. 悅?cè)痪W(wǎng)絡(luò)工作室/悅?cè)粀ordpress建站 專注中小企業(yè)wordpress建站 All Rights Reserved.網(wǎng)站地圖

本站圖片來源為Pexels、Pixabay、Freepik、Unsplash等圖片庫的免費(fèi)許可,CC0協(xié)議;還有部分為自己手繪,版權(quán)碰瓷請自重!法律服務(wù):law@yueranseo.com 蜀ICP備20016391號-1 川公網(wǎng)安備 51011502000367號